Erklärbare künstliche Intelligenz -XAI ist ein Thema, das in den letzten Jahren häufig diskutiert wurde und a Gegenstand von Widersprüchen . Vor der Diskussion Künstliche Intelligenz KI Zuverlässigkeit, wenn die KI versucht, unser Denken und unsere Entscheidungsfindung zu modellieren wir sollten erklären können wie wir wirklich unsere Entscheidungen treffen! Nicht wahr?

VERBINDUNG: KÜNSTLICHE INTELLIGENZ UND DIE FURCHT DES UNBEKANNTEN

Es gibt eine Transformation des maschinellen Lernens, die seit den 1950er Jahren manchmal schneller und manchmal langsamer vor sich geht. In der jüngeren Vergangenheit ist das am besten untersuchte und auffälligste Gebiet maschinelles Lernen mit dem Ziel, das Entscheidungssystem, das Verhalten und die Reaktionen zu modellieren.

Die erfolgreichen Ergebnisse auf dem Gebiet des maschinellen Lernens führten zu einer raschen Zunahme der Implementierung von KI. Vorarbeiten versprechen autonome Systeme, die in der Lage sind, sich selbst wahrzunehmen, zu lernen, Entscheidungen zu treffen und sich zu bewegen.

VERBINDUNG: 13 KOSTENLOSE SEITEN, UM EINE EINFÜHRUNG IN DAS LERNEN VON MASCHINEN ZU ERHALTEN

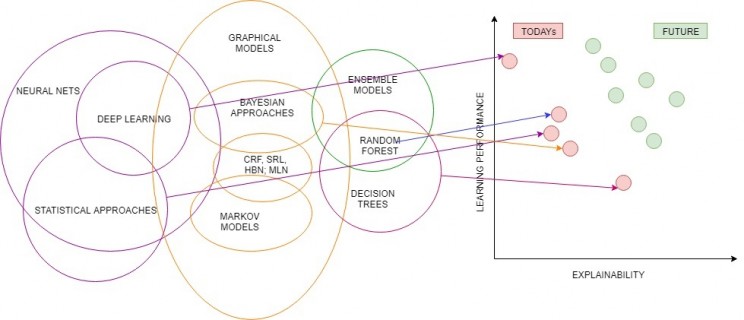

Insbesondere nach den 1990er Jahren basiert das Konzept des tiefen Lernens auf der Vergangenheit, aber die rekursiven neuronalen Netze, Faltungs-neuronalen Netze, das verstärkte Lernen und die umstrittenen Netze sind bemerkenswert erfolgreich. Obwohl erfolgreiche Ergebnisse erzielt werden, ist es nicht ausreichend zu erklären oderErklären Sie den menschlichen Benutzern die Entscheidungen und Aktionen dieser Systeme.

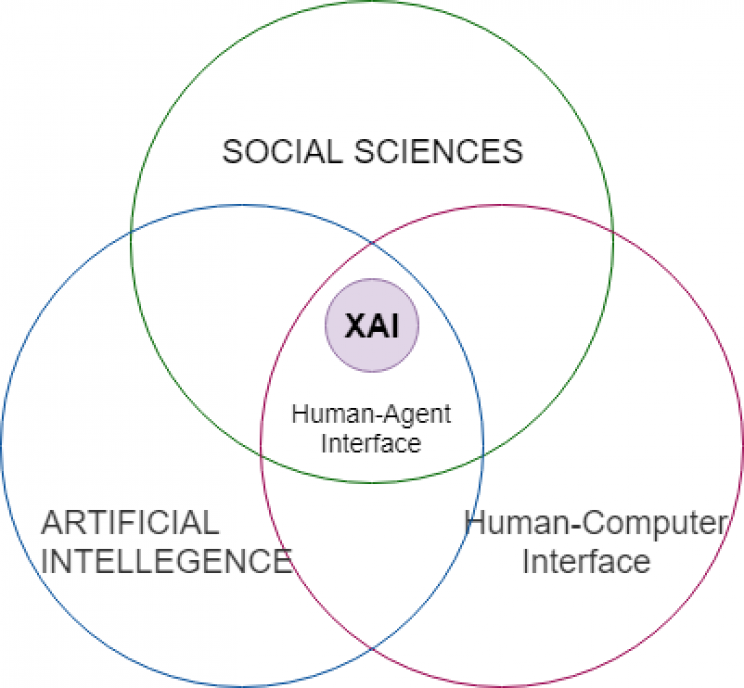

Umfang der erklärbaren künstlichen Intelligenz

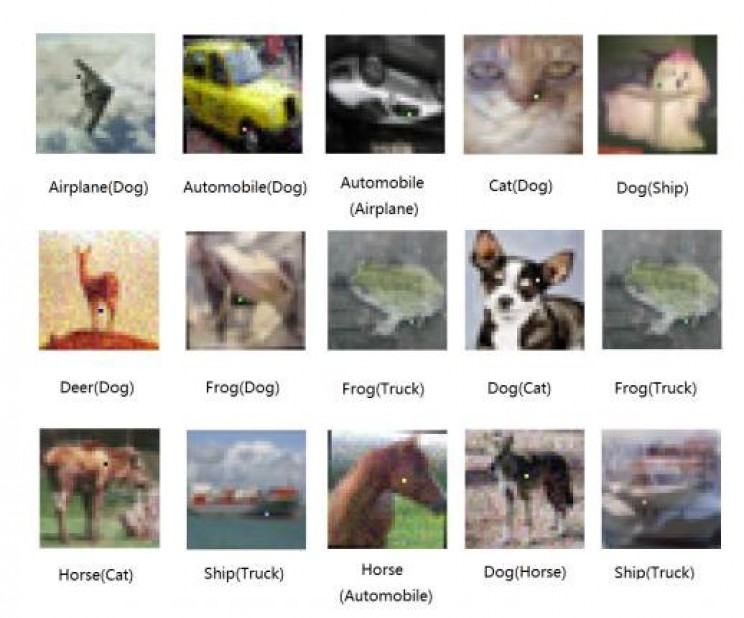

Die Deep-Learning-Modelle, die mit Hunderten von Millionen künstlicher neuronaler Netze entwickelt wurden, sind nicht unfehlbar. Sie können schnell an Glaubwürdigkeit verlieren, insbesondere wenn sie einfach in die Irre geführt werden, wie im Fall eines Ein-Pixel-Angriffs! Dann wird dies unvermeidlichstelle die Frage, wie erfolgreich oder erfolglos!

Das Verteidigungsministerium DoD stellt fest, dass die intelligenteren, autonomen und symbiotischen Systeme vor Herausforderungen stehen.

" Erklärbare KI - insbesondere erklärbares maschinelles Lernen - ist unerlässlich, wenn zukünftige Warfighter eine aufstrebende Generation künstlich intelligenter Maschinenpartner verstehen, angemessen vertrauen und effektiv verwalten sollen. "

Die Komplexität dieser Art von fortgeschrittenen Anwendungen steigt mit den Erfolgen und den Verständnis-Erklärbarkeit wird schwierig. Auch in einigen Konferenzen Es gibt nur Sitzungen, in denen dieses Thema behandelt wird.

Die Gründe für die neuen maschinellen / Deep-Learning-Systeme

Es soll erklären Gründe für neue maschinelle / Deep-Learning-Systeme um ihre Stärken und Schwächen zu bestimmen und zu verstehen, wie sie sich in Zukunft verhalten sollen. Die Strategie zur Erreichung dieses Ziels besteht darin, neue oder modifizierte künstliche Lerntechniken zu entwickeln, die definierbarere Modelle hervorbringen.

Diese Modelle sollen mit modernsten interaktiven Mensch-Computer-Schnittstellentechniken kombiniert werden, mit denen Modelle in verständliche und nützliche Erklärungsdialoge für den Endbenutzer umgewandelt werden können.

Mit drei grundlegenden Erwartungen ist es erwünscht, sich dem System zu nähern :

▪ Erklären Sie den Zweck, wie die Parteien, die das System entwerfen und verwenden, betroffen sind.

▪ Erklären Sie, wie Datenquellen und Ergebnisse verwendet werden.

▪ Erklären Sie, wie Eingaben von einem KI-Modell zu Ausgaben führen.

„XAI ist eines von wenigen aktuellen DARPA-Programmen, von denen erwartet wird, dass sie - die KI-Systeme der dritten Welle - ermöglichen, dass Maschinen den Kontext und die Umgebung verstehen, in denen sie arbeiten, und im Laufe der Zeit zugrunde liegende Erklärungsmodelle erstellen, mit denen sie real charakterisieren könnenWeltphänomene. ”

Wenn wir uns nach Prüfung der Patientendaten aus der medizinischen Praxis auf den Weg machen, sollte sowohl der Arzt verstehen als auch dem Patienten erklären, dass er dem betroffenen Patienten auf Empfehlung des Entscheidungshilfesystems das Risiko eines Herzinfarkts vorgeschlagen hat.

In dieser Phase ist zunächst die Auswertung der Daten ein weiteres wichtiges Kriterium. Es ist auch wichtig zu ermitteln, welche Daten benötigt werden und was für eine ordnungsgemäße Bewertung getan werden muss.

Die Psychologie der Erklärung

Schauen wir uns den Punkt an, an dem wir die Verwendung künstlicher Lerntechnologien ablehnen, weil wir dies nicht erklären können. wie künstliche Intelligenz ihre Entscheidung trifft . Andererseits können so viele Menschen nicht wirklich erklären, wie sie die Entscheidung getroffen haben!

Stellen wir uns vor, wie eine Person auf Modellebene zu einer Entscheidung kam: Wenn wir uns unserer biologischen Struktur auf chemischer und physikalischer Ebene nähern, sprechen wir über elektrische Signale von einer Gehirnzelle zu einer anderen Gehirnzelle. Wenn Sie nicht zufrieden sindmit dieser Erklärung sagst du mir wie Sie beschlossen haben, einen Kaffee zu bestellen !

Wenn einer Ihrer Freunde einen Eiskaffee bestellt hat, hat der andere heißen Kaffee bestellt und der andere eine Tasse Tee in einem Café. Warum wählen sie Eiskaffee und heißen Kaffee? Kann jemand Chemikalien und Synapsen erklären?Kannst du eine solche Erklärung erklären? Weißt du was es ist? Ein Mensch fängt an, eine Geschichte darüber zu erfinden, wie er / sie sich entscheidet! Hoffentlich wird es eine fantastische Geschichte, die du hören wirst, Versuch es!

Schauen Sie sich einfach Ihre Eingabe- und Ausgabedaten an und erzählen Sie dann eine lustige Geschichte! Tatsächlich gibt es einen ähnlichen Ansatz für analytische und wichtige Themen. Interpretationen, Transparenz und Klarheit sind analytisch, und Analysen ohne Test sind wie eine Eins.Weg Zugfahrkarte, die ein Gefühl der Sicherheit schafft.

Unter perfekten Bedingungen;

▪ Ein System mit der besten Leistung

▪. Sie möchten die beste Erklärung.

Aber das wirkliche Leben zwingt uns zu wählen.

Leistung vs. Erklärbarkeit

Interpretation : Sie verstehen, aber es funktioniert nicht gut!

Leistung : Sie verstehen nicht, aber es funktioniert gut!

Insbesondere Akademiker, Forscher und Technologieunternehmen werden im Allgemeinen nicht viel Aufmerksamkeit darauf richten, inwieweit sie der Leistung mehr Bedeutung beimessen. Das Szenario mit den in der Branche tätigen Personen und Institutionen ist jedoch etwas anders. Sie wollen vertrauen und sind es wartet auf eine Erklärung .

KI-Ansätze unterscheiden sich für Banken, Versicherungsunternehmen, Gesundheitsdienstleister und andere unterschiedliche Branchen. Dies liegt daran, dass die Modelle für diese Sektoren unterschiedliche gesetzliche Vorschriften und ethische Anforderungen enthalten. In diesem Fall kommen wir wieder zum selben Punkt. Wenn Sie Ihre möchtenUm das System im folgenden Zustand zu erklären, müssen Sie es durch das einfachere ersetzen, das vorerst nicht zu stark ist!

Forschung zu diesem Thema meistens DARPA, Google, DeepMind usw.. Während die Institutionen weiterhin intensiv betrieben werden, geht aus den Berichten hervor. Unabhängig davon, welcher Sektor und wer von Systemen der künstlichen Intelligenz verwendet wird, besteht ein solcher Zusammenhang zwischen Klarheitund Genauigkeit, dass ein Kompromiss unvermeidlich ist und noch eine Weile andauert.

Schließlich sollte KI nicht in eine göttliche Kraft umgewandelt werden, die wir verfolgen müssen, ohne eine Ursache-Wirkungs-Beziehung herzustellen. Andererseits sollten wir die uns gewährten Erkenntnisse nicht ignorieren.

Grundsätzlich müssen wir darüber nachdenken, flexible und interpretierbare Modelle zu schaffen, die im Einklang mit den Experten arbeiten können, die über Kenntnisse auf technischer und akademischer Ebene und die Meinungen aus verschiedenen Sektoren und Disziplinen verfügen.

Danke

Vielen Dank an Başak Buluz, Yavuz Kömeçoğlu ve Hakan Aydemir für ihr Feedback.