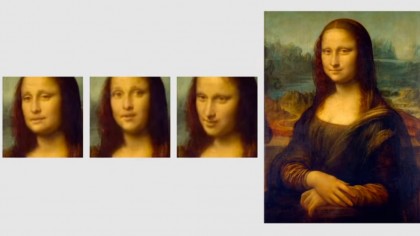

In einer beunruhigenden Entwicklung haben Forscher eine neue Technik entwickelt, um KI-Deepfakes zu erzeugen, bei denen nur der Text eingegeben werden muss, den die Person sagen soll.

Die Störung neuer Technologien wird ohne berechtigten Grund immer besser.

Forscher haben eine neue KI-Deepfake-Software entwickelt, mit der Videos bearbeitet werden können, damit eine Person sagt, was Sie wollen, indem sie einfach das eingibt, was sie sagen soll. Dies ist der nächste Schritt in einer Technologie, die keinen wirklich positiven sozialen Nutzen hathelfen Filmstudios, Geld zu sparen, werden aber garantiert von autoritären Regierungen auf der ganzen Welt missbraucht, um abweichende Stimmen zu diskreditieren. Rache-Porno erzeugen und soziale Konflikte auslösen.

VERBINDUNG: DIESE PERSON BESTEHT NICHT WEBSITE IST EIN CREEPY-BLICK IN DIE ZUKUNFT

Wissenschaftler der Stanford University, der Princeton University, des Max-Planck-Instituts für Informatik und von Adobe Research haben ging voran und demonstrierte auf den ersten Blick, warum Menschen der Technologie misstrauen, indem sie eine neue Softwareplattform entwickelten, mit der Sie das Textprotokoll der aufgezeichneten Sprache einer Person bearbeiten können, um das Video so zu ändern, dass es etwas sagt, was sie eigentlich nicht gesagt haben.

Die Technologie kombiniert ein Phonem, den Begriff für die Verarbeitung natürlicher Sprache für verschiedene Klänge, mit einem Visime, der Gesichtsform, die diese Phoneme bilden, wenn die Person ein Phonem spricht, und verwendet dann eine KI, um das neue Video basierend auf a zu generierenAbschrift dessen, was die Person gesagt hat. Wenn Sie die Abschrift bearbeiten, wird das Video der Person so bearbeitet, dass es mit dem geänderten Text übereinstimmt.

nach die Forscher , "Unser textbasierter Bearbeitungsansatz bildet die Grundlage für bessere Bearbeitungswerkzeuge für die Filmpostproduktion. Gefilmte Dialogszenen erfordern häufig eine Neueinstellung oder Bearbeitung aufgrund kleiner Skriptänderungen, was derzeit mühsame manuelle Arbeit erfordert. Unsere Bearbeitungstechnik ermöglicht dies ebenfallsEinfache Anpassung von audiovisuellen Videoinhalten an bestimmte Zielgruppen: Beispielsweise können Anleitungsvideos an Zielgruppen mit unterschiedlichem Hintergrund angepasst werden, oder ein Storyteller-Video kann an Kinder verschiedener Altersgruppen angepasst werden, die ausschließlich auf der Bearbeitung von Textskripten basieren. Kurz gesagtwurde unsere Arbeit zum Erzählen von Geschichten entwickelt. "

Die Forscher erkennen das Potenzial für schlechte Schauspieler an, ihre Technologie für schändliche Zwecke einzusetzen, und bieten einige mögliche Lösungen für dieses unvermeidliche Problem an.

"Al obwohl die Methoden zur Bild- und Videomanipulation so alt sind wie die Medien selbst ", schreiben die Forscher [ PDF ], "das Missbrauchsrisiko wird bei Anwendung erhöht zu einem Kommunikationsmodus, der manchmal als solcher angesehen wird maßgeblicher Beweis für Gedanken und Absichten. Wir erkennen an dass schlechte Schauspieler solche Technologien verwenden könnten, um den persönlichen Zustand zu verfälschen Äußerungen und Verleumdungen prominenter Personen. Wir sind besorgt über solche Täuschung und Missbrauch.

"Deshalb", fahren sie fort, "glauben wir, dass es wichtig ist, dass Videos mit synthetisiert werden unser Tool präsentiert sich eindeutig als synthetisch. Die Tatsache, dass das Video wird synthetisiert kann durch den Kontext offensichtlich sein z. B. wenn das Publikum un derstands, dass sie einen fiktiven Film sehen, direkt angegeben in das Video oder per Wasserzeichen signalisiert. Wir glauben auch, dass es es ist wichtig, um die Erlaubnis der Darsteller für Änderungen zu erhalten bevor Sie ein resultierendes Video mit einem breiten Publikum teilen. Schließlich ist es wichtig, dass wir als Gemeinschaft die Forensik weiterentwickeln Fingerabdruck- und Überprüfungstechniken digital und nicht digital um manipulierte Videos zu identifizieren. Solche Schutzmaßnahmen würden Reduzieren Sie das Missbrauchspotenzial, während Sie Videos kreativ nutzen können. Bearbeitungstechnologien wie unsere. "

Nehmen wir diese nacheinander.

Erstens zeigt der Vorschlag, dass sich Deepfakes eindeutig als solche präsentieren sollten, ein unglaublich naives Verständnis von Propaganda. Stalin hätte solche Ermahnungen als kurios empfunden, ebenso wie jede autoritäre Regierung oder politische Bewegung in der Zukunft, die diese Technologie gegen Dissidenten und politische Gegner einsetztund ethnische oder religiöse Minderheiten.

Zweitens, wenn eine KI gefälschte Videos erzeugen kann, kann ein KI-Netzwerk ein Wasserzeichen noch einfacher entfernen. Dies ist keine Lösung.

Drittens ist die Zustimmung, Ihre Sprache als Darsteller ändern zu lassen, in der Filmbranche sicherlich positiv, aber dies bedeutet nichts, wenn jemand eine illegale Fälschung anstrebt. Schlechte Schauspieler suchen nicht die Zustimmung, eine falsche Berühmtheit oder Rache zu schaffenPornos oder andere zu verleumden und für eine Agenda zu trüben.

Zuletzt ist es absolut nutzlos, Werkzeuge zur Erkennung von Fälschungen zu erstellen, wenn es um Propaganda geht. Die Protokolle der Ältesten von Zion ist eine zaristische Fälschung über ein Jahrhundert alt und ebenso lange als Fälschung diskreditiert, aber immer noch verwendet, um den weltweiten Antisemitismus erfolgreich zu fördern bis heute . Wie lange dauert es, bis Clips online erscheinen, über die George Soros spricht? mit dem Blut von christlichen Kindern für jüdisches Gebäck? Sollen wir eigentlich glauben, dass der Beweis, dass diese Videos Deepfakes sind, alles ist, was erforderlich ist, um zu verhindern, dass diese Videos unglaublichen Schaden anrichten?

Mit dieser Technologie werden ganze Bevölkerungsgruppen getötet

Die Tech-Industrie ist es gewohnt, als Retter unserer Zeit und unseres Geldes verehrt zu werden und stolz auf ein unternehmerisches Ethos zu sein, das fast an ein grenzt Bioshock- Stufe des objektivistischen Narzissmus, aber die Risse in ihrem öffentlichen Image beginnen sich auszubreiten. Uber- und Lyft-Fahrer sind nähert sich dem Punkt von offener Revolte über Armutslöhne. Facebook versucht es verzweifelt lächerlich um sich selbst dann als "datenschutzorientiertes Netzwerk" umzubenennen verschüttet Persönliche Daten in die Welt wie ein Betrunkener an der Bar, der versucht, an diesem letzten halben Liter Bier festzuhalten. Jetzt können Forscher, die an KI-Deepfakes arbeiten, direkt sagen, dass die Antwort auf den propagandistischen Missbrauch ihrer Technologie a istWasserzeichen oder Vertrauen in andere Technologien, um uns vor den Gefahren der von ihnen geschaffenen Technologie zu bewahren.

Wie die US-Präsidentschaftswahlen 2016 der Welt gezeigt haben, kann eine kostengünstige Informationstechnologie übergroße Auswirkungen haben, und der propagandistische Wert von Deepfakes auf der ganzen Welt ist schrecklich. Wir müssen auch nicht warten, um dieses Spiel zu sehen.es darf schon passiert. Ein neuer Silvester Video Der Präsident von Gabun, Ali Bongo Ondimba, löste eine politische Krise aus, nachdem einige Kritiker - darunter das Militär des Landes - das Video als eine Fälschung herausgefordert hatten, die den gegenwärtigen Zustand des Präsidenten verbergen sollte.

Ob das Video eine Deepfake ist oder nicht, ist unklar und ehrlich gesagt nebensächlich. Die Tatsache, dass diese Technologie existiert, schadet in beiden Fällen. Gefälschte Videos können verwendet werden, um Oppositionsfiguren zu diskreditieren, fehlgeschlagene Anführer zu stützen oder andere Fehlinformationen zu verbreiten.oder die Leute können jetzt die Videodokumentation von Dingen, die sie nicht mögen, als "Deepfakes" abtun, selbst wenn sie echt sind. Die Ermittlung der Authentizität von Videos ist genauso nützlich wie die Überprüfung von Fakten bei der Bekämpfung der Verbreitung gefälschter Nachrichten.

Die Forscher, die diese neue Softwaretechnologie entwickelt haben, fordern alle Arten von Sicherheitsvorkehrungen, die getroffen werden sollten, um die Welt vor den Folgen ihrer Technologie zu schützen, aber während sie sich beeilen, die Technologie zur Produktion gefälschter Videos zu entwickeln, ist niemand dascheint alles daran interessiert zu sein, diese Schutzmaßnahmen zu entwickeln.

Stattdessen vertrauen die Forscher hinter dieser neuesten Software im Wesentlichen darauf, dass die Weltbevölkerung, von der die meisten unterschiedliche Informationsniveaus für ihre Informationsquellen haben, selbst erkennen wird, ob es sich um das Video handelt, das sie gerade im Regierungsfernsehen gesehen habeneine tiefe Fälschung oder nicht. Sie können sich anscheinend nicht die Mühe machen, dies selbst zu tun.

Die Konsequenzen dieser Technologie sind nicht zu unterschätzen. 1994 wurde ein Flugzeug mit dem Präsidenten von Ruanda abgeschossen, wobei alle an Bord getötet wurden. Die Hutu-Regierung in Ruanda beschuldigte eine Tutsi-Rebellenarmee für den Angriff und löste a hunderttägiger Völkermord von Tutsi-Zivilisten, die fast eine Million Menschenleben forderten. verschiedene Konflikte Auf dem Balkan sind seit dem Zerfall Jugoslawiens mehr als hunderttausend Menschen ums Leben gekommen, und die Regierungen haben lange Zeit Fehlinformationen und regelrechte Fälschungen verwendet, um Pogrome gegen Juden und andere verfolgte Minderheiten in der Geschichte der Menschheit anzuregen.

Solche Spannungen bestehen derzeit auf der ganzen Welt und warten darauf, dass ein Brennpunkt diese Spannungen in Krieg und Völkermord auslöst. Eine tiefe Fälschung eines prominenten Führers religiöser oder ethnischer Minderheiten oder einer Figur, die ein schreckliches Verbrechen "gesteht", wäreEine solide "Rechtfertigung" für die Anstiftung zu einem Völkermord, auf die sich die Völkermorde in der Vergangenheit verlassen haben. Bis heute weiß niemand, wer das Flugzeug des ruandischen Präsidenten abgeschossen hat, aber alles, was nötig war, war die energische Anschuldigung, das Gemetzel ins Rollen zu bringen.

Nicht alle Situationen sind 1994 in Ruanda, manchmal reicht eine Anklage nicht aus - aber wer braucht eine Anklage, wenn man ein "Geständnis" ablegen kann? Nichts hindert eine Deepfake daran, das 21. Jahrhundert zu werden. Protokolle der Ältesten von Zion - Tatsächlich ist garantiert, dass eine solche Fälschung jetzt unvermeidlich ist und Menschen sicherlich daran sterben werden. Viele Menschen.

In seinem Mutter Jones Geschichte über die gabunische Deepfake-Kontroverse Ali Breland schreibt : "Während sich die meisten Medienberichte über Deepfakes auf Horrorszenarien konzentrierten, in denen sie gegen die USA und andere westliche Länder eingesetzt wurden, warnen Experten, dass Deepfakes in Entwicklungsländern, in denen häufig fragile Regierungen leben, das größte Chaos anrichten könntenund möglicherweise ein gefälschtes Video von Jeff Bezos, CEO von Amazon, der den Ruhestand ankündigt und einen Aktienkurs auslöst. Fehlinformationen in einigen Ländern könnten zu Staatsstreichen, geschlechtsspezifischer oder ethnisch motivierter Gewalt führen und die Stabilität ganzer Staaten gefährden."

In a aktuelles Stück In der New York Times glaubt Dr. Regina Rini, Philosophielehrerin an der York University in Toronto, dass es bereits zu spät ist, umzukehren, und dass wir uns darauf vorbereiten müssen, Videos eher als Zeugenaussagen als als dokumentarische Beweise zu behandeln. "[I] Es ist klar, dass aktuelle Argumente über gefälschte Nachrichten nur einen Vorgeschmack darauf geben, was passieren wird, wenn Ton und Bild, nicht nur Worte, von jedem mit einem anständigen Computer manipuliert werden können. "

Ethik, Shmethics

Hätten die an der Herstellung dieser Technologie beteiligten Personen eine angemessene Unterweisung in Ethik - oder sogar nur in der Geschichte - erhalten, hätte diese Technologie niemals die Vorschlagsphase verlassen, und jeder, der darauf drängte, wäre von Managern entlassen worden, die hatte erhielt eine angemessene ethische Ausbildung. Da niemand in den Unternehmen und Institutionen, die diese Technologie entwickelt haben, der Meinung zu sein scheint, dass solche Überlegungen ausreichend sind, um den Bau dieser Technologie zu verhindern, könnte es an der Zeit sein, dass die Gesellschaft eingreift und zügeltdiese Leute mit Regulierung.

Die fraglichen Forscher scheinen diesen Punkt selbst zu schätzen, wenn sie schreiben "Wir glauben, dass ein solides öffentliches Gespräch notwendig ist, um eine Reihe geeigneter Vorschriften und Gesetze zu schaffen, die das Risiko des Missbrauchs dieser Tools gegen die Bedeutung kreativer, einvernehmlicher Anwendungsfälle abwägen." Es hätte niemals so weit kommen dürfen.Da jedoch die "kreativen, einvernehmlichen Anwendungsfälle" neben dem enormen Schaden, den der "Missbrauch" ihrer Technologie verursachen wird, an Bedeutung verlieren. Wenn man sie gegeneinander abwägt, hätte jede vernünftige Person zu dem Schluss kommen können, dass dies unter keinen Umständen der Fall istEin Vorteil dieser Technologie für die Industrie rechtfertigt den Schaden, den diese Technologie für die Gesellschaft anrichten wird. Es scheint jedoch, dass der Technologiebranche vernünftige Menschen fehlen, da sie sich eindeutig nicht selbst helfen können, wenn sie einen anderen Faden des sozialen Gefüges sehen, den sie "stören" können".

Diese Technologie bedeutet bereits, dass wir dem, was wir sehen, nicht mehr mit eigenen Augen vertrauen können. Man könnte argumentieren, dass wir immer wachsam gegenüber Fehlinformationen sein sollten, aber auch dies ist naiv. Wer möchte jeden wachen Moment mit Lesen und Betrachten verbringenoder Informationen mit dieser Art von harter Skepsis verdauen, die ganze Zeit ? Dies erfordert ein Maß an Bildung und geistiger Energie, das nicht jeder besitzt und das niemand für immer aufrechterhalten kann. Die Gesellschaft baut letztendlich auf einem bestimmten Maß an Vertrauen auf. Diese Technologie zerstört einfach einen Teil des hart erkämpften Vertrauens ineinanderdas kann nicht einfach repariert werden, wenn überhaupt.

Aber hey, wenn Sie eine kleinere Skriptbearbeitung haben und 15 Sekunden Dialog neu aufnehmen müssen, ist diese Technologie die sozialen Kosten absolut wert.