Die AI-Computing-Plattform von NVIDIA hat in der letzten Runde der Inferenztests, die über das Branchen-Benchmarking-Konsortium durchgeführt wurden, erneut Leistungsrekorde gebrochen. MLPerf Laut einer Pressemitteilung, die im Rahmen eines Embargos mit Interessante Technik | wissenschaft-x.com geteilt wurde.

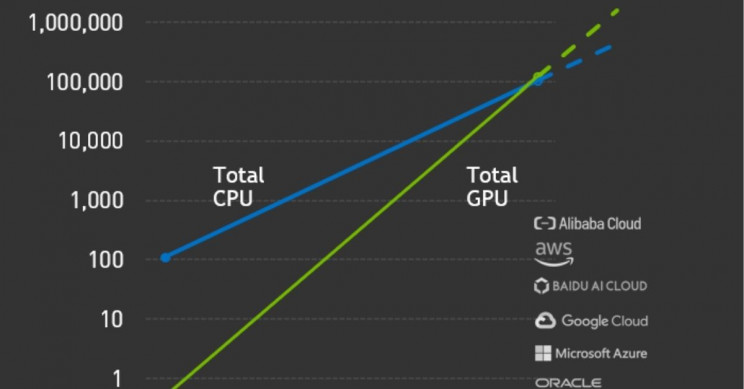

Zum ersten Mal gibt es auf Cloud-Service-Plattformen mehr GPUs als CPUs mit aktiver Inferenzleistung.

Insgesamt baut dies den Vorsprung von NVIDIA als einziger unabhängiger Marktführer in Bezug auf KI-Leistung, -Dienste und -Software erheblich aus, da KI-Anwendungen zu mehr Mainstream-Anwendungen als je zuvor werden.

VERBINDUNG: NVIDIA BAUT 52 MILLIONEN USD SUPERCOMPUTER FÜR AI HEALTH RESEARCH

NVIDIA schlägt AI-Computing-Benchmark, GPUs übertreffen CPUs

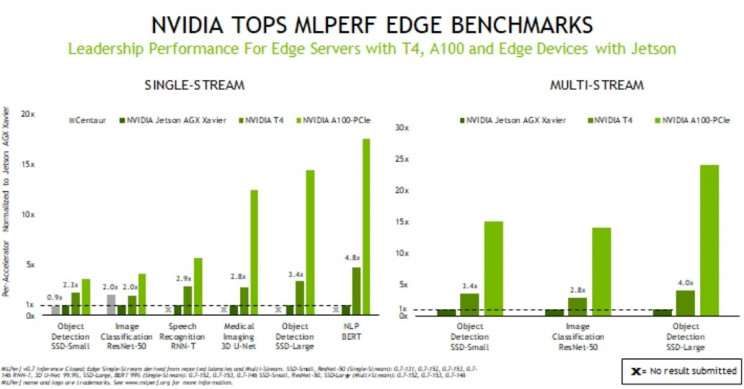

NVIDIA-GPUs haben in der letzten Runde der einzigen konsortialbasierten Peer-Review-Benchmarks in der Branche jeden Test der KI-Inferenz in Rechenzentren und Edge-Computersystemen gewonnen. Bei Edge-Computing handelt es sich um KI, die an den Aktionspunkt gebunden istZum Beispiel müsste eine KI-Sicherheitsdrohne bauen. Echtzeit Entscheidungen ohne Verzögerung der Verbindung oder Fernbedienung.

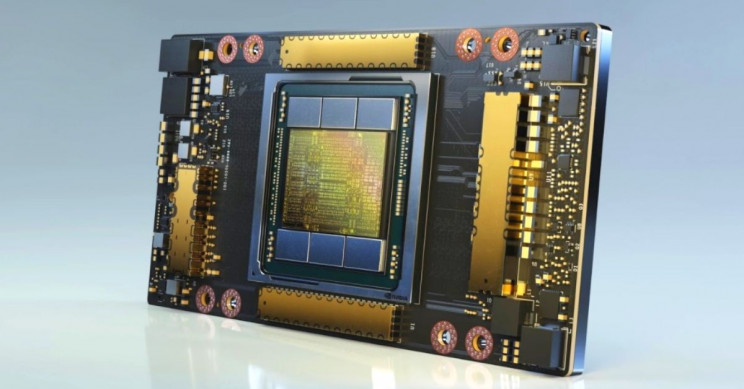

NVIDIAs A100 Tensorkern GPUs übertrafen frühere Ergebnisse, die bei den ersten AI-Inferenztests im vergangenen Jahr gezeigt wurden - mit freundlicher Genehmigung von MLPERF - einem im Mai 2018 gegründeten Benchmarking-Konsortium für die Branche.

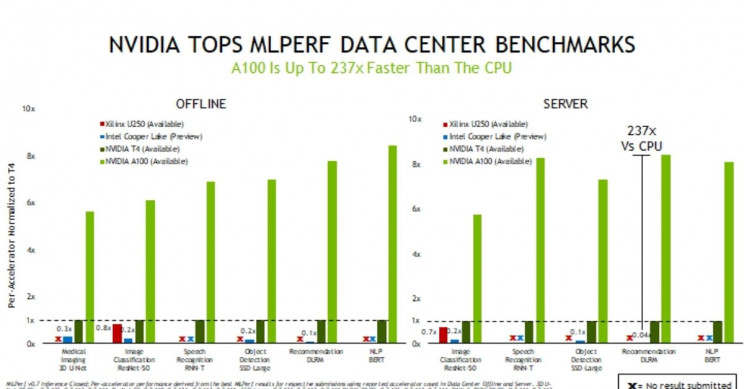

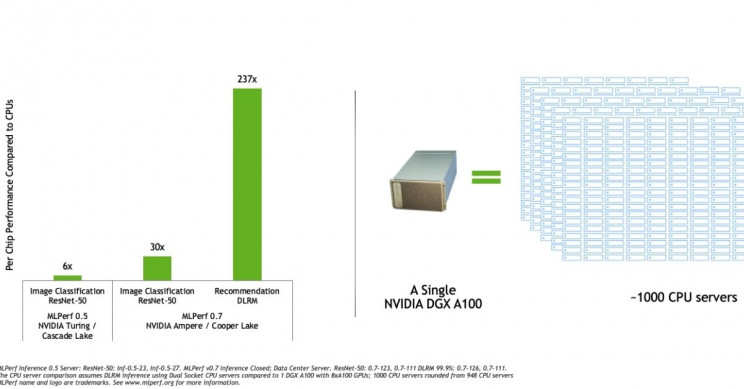

Eine andere GPU namens A100, die im Mai dieses Jahres eingeführt wurde, zeigte CPU-Konkurrenten - mit einem Vielfachen der bis zu 237-mal besseren Leistung bei der Inferenz von Rechenzentren - laut 0,7 Benchmarks von MLPerf Inference.

Die NVIDIA T4-GPUs mit kleinem Formfaktor und energieeffizienten GPUs übertrafen die CPU-Leistung um ein Vielfaches von 28-mal besser. Als Referenz kann ein NVIDIA DGX A100-System mit acht A100-GPUs die gleiche Leistung bieten wie fast 1.000 Dual-Socket-CPUsServer in wichtigen KI-Anwendungen.

Insbesondere an dieser letzten Runde von Benchmark-Tests über MLPerf nahmen mehr Teilnehmer teil - mit Einsendungen von 23 Organisationen, gegenüber 12 in der letzten Runde. Entscheidend ist, dass NVIDIA-KI-Partner, die die KI-Plattform des Unternehmens betreiben, mehr als 85% der Leistung erbrachtenaller Einsendungen.

A100-GPUs, Jetson AGX Xavier, Edge Performance

Zusätzlich hat der NVIDIA Jetson AGX Xavier den Vorsprung bei SoC-basierten Edge-Geräten unter eingeschränkter Leistung ausgebaut - mit Unterstützung für alle praktischen Anwendungsfälle.

Die neuesten Ergebnisse stellen einen "Wendepunkt" der Verbreitung im AI-Ökosystem dar. 1.029 Ergebnisse wurden mit NVIDIA-Produkten eingereicht. Zu den Einsendungen gehörten Partner wie Cisco, Fujitsu, Cisco, Altos, Alto, Dividiti, Lenovo, QCT, Gigabyte,Nettrix und Inspur.

MLPerf genießt breite Unterstützung in der Wissenschaft und in verschiedenen Branchen und setzt Maßstäbe für Organisationen wie Facebook, Google, Microsoft, Arm, Baidu, Harvard, Lenovo, Intel, Stanford und die University of Toronto.

Neueste Benchmarks sind medizinische Bildgebung, Spracherkennung

Die neuesten über MLPerf angebotenen Benchmarks umfassen vier neue Tests - Nachweis von AIs expandierende Landschaft . Die neue Testsuite bewertet jetzt die Leistung in den Bereichen medizinische Bildgebung, Spracherkennung, Verarbeitung natürlicher Sprache, Empfehlungssysteme und auch AI-Anwendungsfälle in der Bildverarbeitung.

"Die jüngsten KI-Durchbrüche beim Verständnis natürlicher Sprachen machen eine wachsende Anzahl von KI-Diensten wie Bing natürlicher, mit denen sie in weniger als einer Sekunde genaue und nützliche Ergebnisse, Antworten und Empfehlungen liefern können", sagte Microsoft Vice President für Suche undkünstliche Intelligenz Rangan Majumder.

"MLPerf-Benchmarks nach Industriestandard liefern relevante Leistungsdaten in weit verbreiteten KI-Netzwerken und helfen, fundierte Kaufentscheidungen für KI-Plattformen zu treffen", fügte Majumder hinzu.

KI-Anwendungen retten Leben in der COVID-19-Krise

Ein erheblicher Einfluss wurde beobachtet, wenn die KI eine Rolle spielte. medizinische Bildgebung . Zum Beispiel verwendet ein Startup namens Caption Health AI, um das Abrufen von Echokardiogrammen zu vereinfachen - ein Verfahren, das in den ersten Tagen der COVID-19-Krise nachweislich Leben in US-Krankenhäusern rettet.

Aus diesem Grund werden AI-Ansichtsmodelle wie 3D U-Net, die in den letzten MLPerf-Benchmarks verwendet wurden, als entscheidend angesehen.

"Wir haben eng mit NVIDIA zusammengearbeitet, um Innovationen wie 3 U-Net auf den Gesundheitsmarkt zu bringen", sagte Klaus Maier-Hein, Leiter des Medical Cancer Computing des Deutschen Krebsforschungszentrums am DKFZ.

"Computer Vision und Bildgebung bilden den Kern der KI-Forschung, treiben wissenschaftliche Entdeckungen voran und stellen Kernkomponenten der medizinischen Versorgung dar. MLPerf-Benchmarks nach Industriestandard liefern relevante Leistungsdaten, mit denen IT-Organisationen und Entwickler ihre spezifischen Projekte und Anwendungen beschleunigen können."fügte Maier-Hein hinzu.

AI-Anwendungsfälle in kommerziellen Umgebungen haben bereits große Wellen geschlagen. Beispielsweise verwendete Alibaba im November 2019 Empfehlungssysteme für eine Online-Verkaufstransaktion in Höhe von 38 Milliarden US-Dollar während des Singles Day - dem größten Einkaufstag des Unternehmens des Jahres.

Die Übernahme von NVIDIA AI Inference hat den Wendepunkt überschritten.

Durchschneiden des technischen Rauschens endloser Benchmarks, NVIDIAs AI Inferenz übertrifft einen bedeutenden Meilenstein in diesem Jahr - mit seinen GPUs, die im letzten Jahr insgesamt mehr als 100 Exaflops der AI-Inferenzleistung in der gesamten öffentlichen Cloud liefern.

Mit anderen Worten, die gesamte auf NVIDIA-GPUs ausgeführte Cloud-AI-Inferenz-Rechenkapazität überholte zum ersten Mal Cloud-CPUs - nach einem Wachstumstrend von etwa 10 alle zwei Jahre.

Da die KI weiterhin zu Organisationen und Branchen mit interner Infrastruktur wächst, werden Unternehmen wie NVIDIA mit Sicherheit zu einer allgegenwärtigen Facette des täglichen Lebens. GPU-beschleunigte Software Das Ausführen von NVIDIA-zertifizierten OEM-Systemen in Cloud-Systemen ist für die Zukunft schnell weniger unvermeidlich als der heutige Standard.