MIT arbeitet an der Entwicklung eines tragbaren KI-Systems, das die Stimmung eines Gesprächs genau vorhersagen kann.

Die Art und Weise, wie eine Person die Stimmung und den Ton eines Satzes artikuliert, kann die Bedeutung eines Gesprächs erheblich verändern. Letztendlich wird die Interpretation der Bedeutung dem Zuhörer überlassen. Die Fähigkeit, die Emotionen zu unterscheiden, die eine Person darstellt, ist eine entscheidende Komponentedes Gesprächs. Allerdings ist nicht jeder in der Lage, zwischen den Tönen zu unterscheiden.

Für manche Menschen, insbesondere solche, die unter Angstzuständen oder Aspergern leiden, kann ein Gespräch anders als beabsichtigt ablaufen. Die Fehlkommunikation kann soziale Interaktionen extrem stressig machen.

Forscher vom MITLabor für Informatik und künstliche Intelligenz CSAIL und Institut für Medizintechnik und Wissenschaft IMES sagen, dass sie möglicherweise die Lösung haben: ein tragbares KI-Gerät, das in der Lage ist, zu unterscheiden, ob ein Gespräch glücklich, traurig oder neutral ist, indem es die Sprechweise einer Person aktiv überwacht.

"Stellen Sie sich vor, Sie könnten es am Ende eines Gesprächs zurückspulen und die Momente sehen, in denen sich die Menschen um Sie herum am ängstlichsten fühlen." sagtDoktorand Tuka Alhanai, „Unsere Arbeit ist ein Schritt in diese Richtung und deutet darauf hin, dass wir vielleicht nicht so weit von einer Welt entfernt sind, in der die Leute einen KI-Social-Coach direkt in der Tasche haben.“

Die stimmungsvorhersagenden Wearables analysieren aktiv die Sprachmuster und physiologischen Signale einer Person, um die Töne und Stimmungen zu bestimmen, die in einem Gespräch zum Ausdruck kommen 83 Prozent Genauigkeit. Das System ist so programmiert, dass es während eines Gesprächs alle fünf Sekunden einen „Sentiment Score“ aufzeichnet.

„Soweit wir wissen, ist dies das erste Experiment, das sowohl physikalische Daten als auch Sprachdaten auf passive, aber robuste Weise sammelt, selbst während die Probanden natürliche, unstrukturierte Interaktionen haben“, sagt Ghassemi. „Unsere Ergebnisse zeigen, dass es möglich ist, den emotionalen Ton von Gesprächen in Echtzeit zu klassifizieren.“

Deep-Learning-Techniken werden die Leistung des Systems weiter verbessern, da immer mehr Menschen das System verwenden und mehr Daten für die Algorithmen zur Analyse erstellen. Um die Privatsphäre des Benutzers zu schützen, werden die Daten lokal auf einem Gerät verarbeitet, um potenzielle Privatsphäre zu verhindernEs können jedoch weiterhin Datenschutzbedenken bestehen, da das Gerät möglicherweise die Gespräche unauffälliger Personen aufzeichnen kann.

Funktionsweise des Geräts

Frühere Studien, die die Emotion eines Gesprächs untersuchten, erforderten, dass ein Teilnehmer eine bestimmte Emotion künstlich auslebte. Um mehr organische Emotionen zu erzeugen, ließen MIT-Forscher die Teilnehmer stattdessen eine glückliche oder traurige Geschichte erzählen.

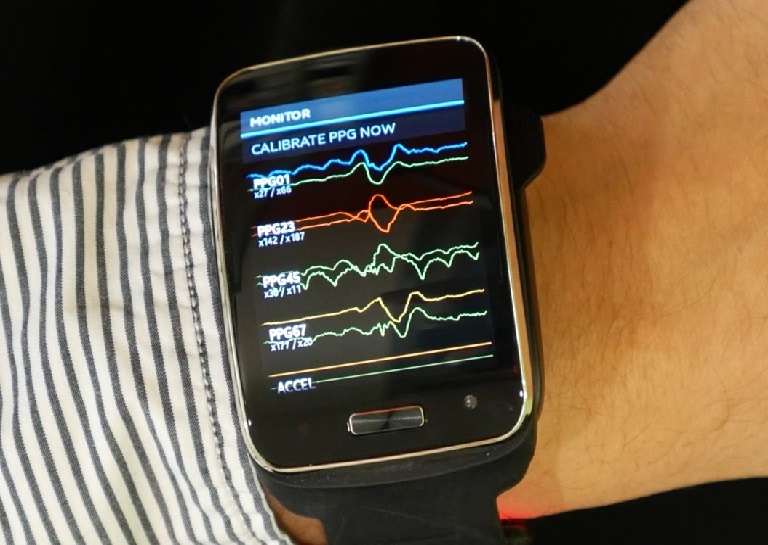

[Bildquelle: MITCSAIL/YouTube]

[Bildquelle: MITCSAIL/YouTube]

Die Teilnehmer der Studie trugen ein Samsung Simband – ein Gerät, das hochauflösende physiologische Wellenformen erfassen kann, um viele Attribute zu messen, einschließlich Herzfrequenz, Blutdruck, Durchblutung und Hauttemperatur. Das Gerät zeichnet auch gleichzeitig Audiodaten auf, die dann analysiert werden, um festzustellen Ton, Tonhöhe, Energie und Wortschatz.

„Die Nutzung von Consumer-Market-Geräten durch das Team zum Sammeln von physiologischen Daten und Sprachdaten zeigt, wie nah wir an solchen Tools in alltäglichen Geräten sind“, sagt Björn Schuller, Professor und Lehrstuhlinhaber für Komplexe und Intelligente Systeme an der Universität Passau in Deutschland. „Technologie könnte sich bald emotional viel intelligenter oder sogar ‚emotional‘ anfühlen.“

MIT-Forscher zeichneten 31 Gespräche auf und verwendeten dann die Daten, um zwei separate Algorithmen zu trainieren. Der erste leitet das Gespräch ab, um es entweder als glücklich oder traurig zu kategorisieren. Der sekundäre Algorithmus bestimmt, ob das Gespräch über 5 Sekunden positiv, negativ oder neutral istIntervalle.

„Das System greift beispielsweise auf, dass die Stimmung in der Texttranskription abstrakter war als die Rohdaten des Beschleunigungsmessers“, sagt AlhanaiInput von uns als Forschern.“

Funktioniert es?

Überraschenderweise haben die Algorithmen erfolgreich die meisten Emotionen bestimmt, die ein Mensch während eines Gesprächs erwarten würde. Die Ergebnisse des Modells waren jedoch nur 18 Prozent über Wahrscheinlichkeit.Trotz des geringen Prozentsatzes bleibt die neue Technik eine vollständige 7,5 Prozent genauer als bestehende Ansätze.

Leider ist das Modell noch zu unterentwickelt, um als Social Coach einen praktischen Nutzen zu haben. Die Forscher planen jedoch, die Datenerhebung zu skalieren, indem das System auf kommerziellen Geräten wie der Apple Watch verwendet werden kann.

„Unser nächster Schritt besteht darin, die emotionale Granularität des Algorithmus so zu verbessern, dass er langweilige, angespannte und aufgeregte Momente genauer hervorruft, anstatt Interaktionen nur als ‚positiv‘ oder ‚negativ‘ zu bezeichnen.“sagtAlhanai. „Die Entwicklung von Technologien, die den Puls menschlicher Emotionen messen können, hat das Potenzial, die Art und Weise, wie wir miteinander kommunizieren, dramatisch zu verbessern.“

SIEHE AUCH: Gefässe, die Musik, die durch physiologische Signale von Emotionen erzeugt wird

Geschrieben von Maverick Baker